百度与谷歌是我们SEO工作中接触最多也是谈到最多的两个搜索引擎,大的方面就不说了,那么在于中文分词上面,百度搜索引擎具有明显的

优势,毕竟是全球最大的中文搜索引擎嘛,那么谷歌在识别中文分词这块与百度有什么样的区别呢,Sofia下面结合知乎上的一篇技术文章给大家简单分析下。

虽然说我们目前所做的SEO工作基本上都是针对百度的,但是客观上来说,在与搜索相关的基础技术方面,百度距离 Google 仍有很大的差距。

google与百度的计算资源差距

机群管理的技术水平决定你能拥有和有效使用多少硬件资源,大规模计算与存储决定你能在这些硬件上做多大规模的事情 ,

而最后,搜索引擎本身就是一套大规模机器学习系统,而在这方面,百度永远不及谷歌。

百度与谷歌的分词技术

百度的中文分词

「百度更懂中文」的一个集中体现。

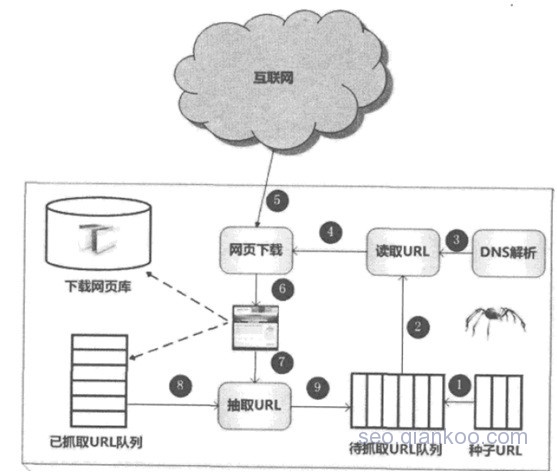

百度做中文分词是这样一个模型:先从一个人工编辑好的字典开始,用这个字典跑一些网页,观察分析里面的 bad case 。

由于分词过细或者其他原因,或者是中文人名或者特殊名词没分出来,然后就尝试根据中文语法规律加入规则,或添加词表来解决这些 bad case,

如此往复,直到有满意的结果。上线应用,发现有新的 bad case 就再研究加规则,当然也有自动流程发现和确认如「喜大普奔」之类的新词,

这时候体对于长尾头部的一千个热词,百度的人工编辑的优势就能够体现出来了,而且效果也是非常可观的。

Google,技术碾压一切

Google 做分词的话就是把问题看成一个概率问题:如果中文网页中哪些字经常一起出现,那么它们很有可能就是一个词。看哪些词后面会跟的地得,的地得后面有常跟哪些词,语法结构也就出来了。

解题思路就是把所有抓到的中文网页往 MapReduce 里一丢,参数算出来就好了。评估分词质量的方法也很简单,就拿新模型放到网页检索的模型里,做个实验看质量有没提升就行。

这套方法结果之好,基本把中文分词做成了一个没有多少悬念的简单问题,而且基本不需要中文语言专家的参与。

同时这也就是 Google 做 Translate 的思路。这里面基本方法其实非常简单,但是你得先有这么多的网页数据,还得有大机群,有分布计算框架,还有可复用的模型……

这些资源是百度所没有的。

在技术受限的条件下,人工微调优化结果是一个恰当的产品思路,但这个产品思路会与技术发展路线相互影响。

Google 的主流技术思路则是骨子里不相信人工调整,什么事情都非得弄出个自动通用可扩展的模型来不可,这种思路可能一开始在那一千个热词上怎么都比不过勤劳接地气的编辑,但通过积累数据调整模型,假以时日,整体结果质量就会显著提升。

以上,你怎么看

.jpg)

.png)

![Connectify Dispatch指定程序使用指定网卡[运维神器]](http://www.vuln.cn/wp-content/uploads/2016/11/1.jpg)

![网站备案流程_网站备案需要什么[简单明了解决备案各种问题]](http://www.vuln.cn/wp-content/uploads/2014/03/topleft.gif)

![最新BurpSuite 1.7.32 破解版[注册机]下载【无后门版】](http://www.vuln.cn/wp-content/uploads/2018/02/ee462f76d3e2440f67041f92499c36ae.png)

![php一句话后门的几种变形分析[preg_replace函数]](http://www.vuln.cn/wp-content/uploads/2016/11/11.jpg)

![[网盘下载] PSD模板文件 - 计算机软件著作权登记证书在线生成](http://www.vuln.cn/wp-content/uploads/2021/04/217daf7afff4b2fcd9725590b97d6427.png)

![[网盘下载] GB/T 23031. 1 — 2022 工业互联网平台 应用实施指南 第一部分:总则.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/3faee12ec28ab59793fbe1c203b8363f.png)

![[网盘下载] GB/T 41870-2022 工业互联网平台 企业应用水平与绩效评价.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/4ec246e126c4f3a41d9ced588c790998.png)

![[网盘下载] GB/T 36323-2018 信息安全技术 工业控制系统安全管理基本要求.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/f6adb0f6fa49a734846c5873d178bfbc.png)

![[网盘下载] GB/T 32919 -2016 信息安全技术 工业控制系统安全控制应用指南.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/da9420e72b7af6bfb4fa273884dcefc1.png)

云悉指纹

云悉指纹