给大家从普通get请求上来剖析一些白帽或者白帽手段,你会发现干预一个普通get请求就能够达到很多目的,无论是好是坏。

当然以下内容不提倡大家用于非法用途。

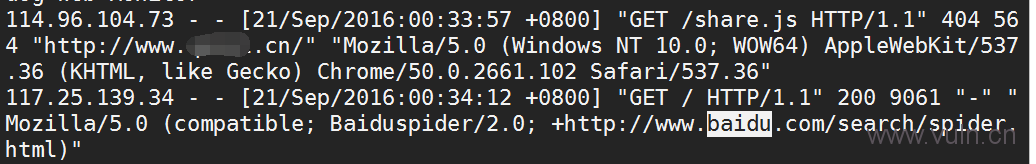

百度蜘蛛的那些事

现在回想起那些年被奉为高大上职业的SEO,简直可笑,也是是角度不同看待的层面也不同,seo的角度是排名与变现;而技术的角度则是:

百度服务器(百度蜘蛛)会向网站发送get请求,得到响应后会缓存到服务器上(快照),百度会对这些缓存页面进行质量度,重复度,页面内其他连接爬去等等方面进行分析,同一个网站的域名下所有页面归结于顶级域名(权重),那么问题来了,百度从哪能够向我的网站发送请求?这就需要外链了,爬取其他网站的时候就能够进入你的网站。

以上是从web基本的请求对seo进行的一个笼统概述。

既然我们知道百度爬取网站就仅仅只是一个客户端(百度spider)请求网站的过程,那么这个过程我们就可以人为的干预它。

1.我们知道百度蜘蛛的user-agent是baiduspider,那么我们可以在程序上做很多判断,比如彻底屏蔽百度蜘蛛(实际上robots.txt上屏蔽很多时候并不彻底,它想爬就能爬,而你却无可奈何)

2.快照劫持,排名劫持等等也都是判断user-agent来让baiduspider爬指定的页面。

$agent = $_SERVER['HTTP_USER_AGENT']; if (stristr($agent, 'Baiduspider')) { header("Location:http://www.vuln.cn"); }

另外,一般如果流量劫持的话会判断referrer,如果是从百度搜索结果来的才跳转。

以上都是普通的get请求的判断。

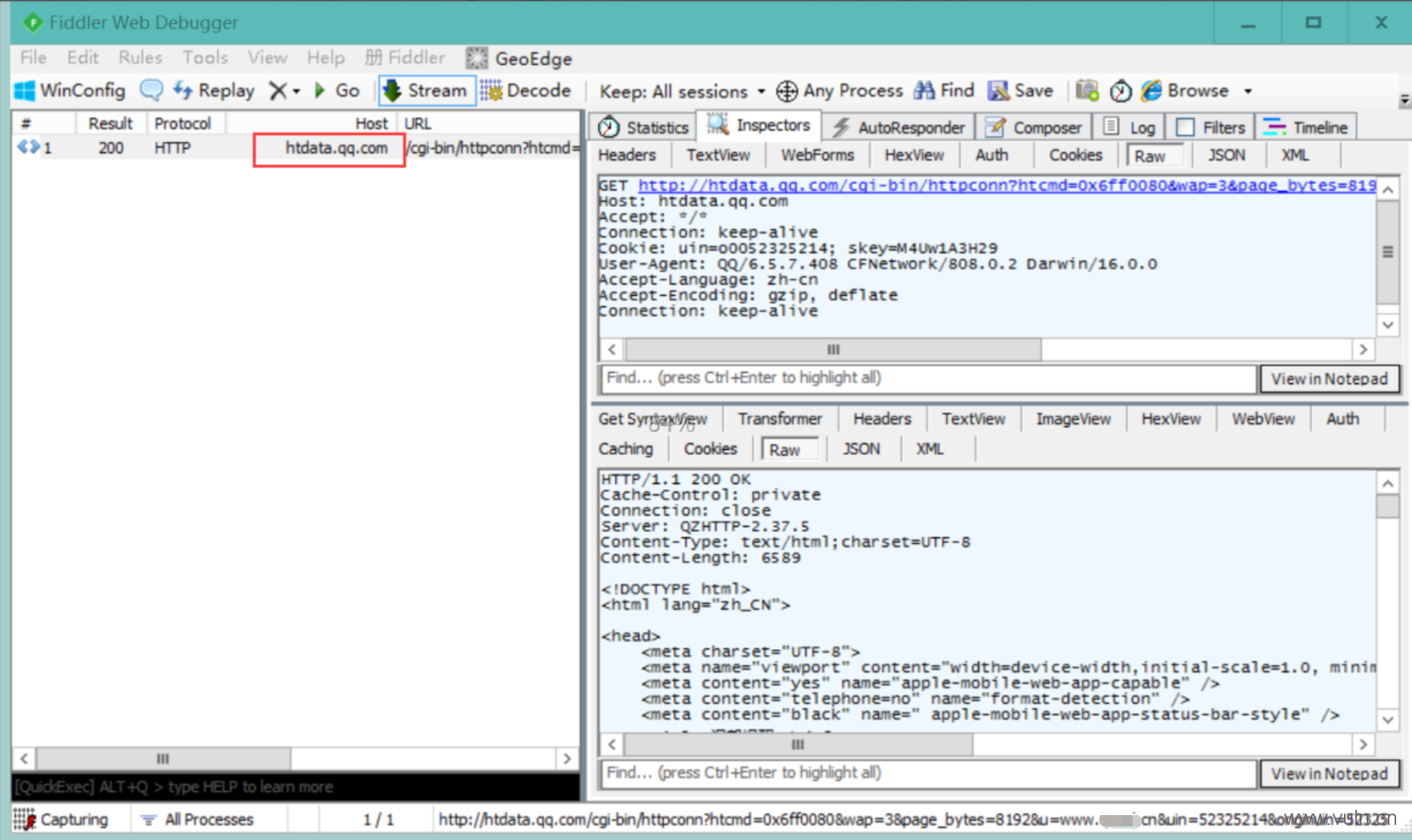

QQ判断一个网址是危险还是安全

当我们在qq聊天窗口上发送一个url链接的时候往往qq会直接提示安全性未,风险或安全,当然这也是qq的一个普通get请求而已,因为当你回车发送一个url地址的时候,qq就会有好几个服务器来请求这个url,判断这个url与url内容。

如果这个url在黑名单那么就会提示风险,再判断响应内容,比如网页上有让你填写用户名与密码的地方qq就会提示你有风险不要随便填。

现在的qq对网页内容已经能判断的非常到位了,如果是不经过处理的钓鱼页面直接会弹窗不让你输入账号。

实例

非风险名单也非绿标域名全部问号

聊天窗口发送后,会立即有一个请求

完整请求:

GET http://htdata.qq.com/cgi-bin/httpconn?htcmd=0x6ff0080&wap=3&page_bytes=8192&u=www.***.cn&uin=52325214&originuin=52325214 HTTP/1.1 Host: htdata.qq.com Accept: */* Connection: keep-alive Cookie: uin=o0052325214; skey=M4Uw1A3H29 User-Agent: QQ/6.5.7.408 CFNetwork/808.0.2 Darwin/16.0.0 Accept-Language: zh-cn Accept-Encoding: gzip, deflate Connection: keep-alive

对应的,网站服务器上也会有一个腾讯服务器请求日志,一个url在一段时间内只会去检查一次。

user-agent为:MSIE 6.0,MSIE 6.0

诸如此类,但并不是每次都一样,毕竟用来检测的服务器种类与数量都会由很多。

那么思路来了,如果自己网站被qq报危险了,怎么做呢?思路已经提供,具体细节就不细说了。

![Connectify Dispatch指定程序使用指定网卡[运维神器]](http://www.vuln.cn/wp-content/uploads/2016/11/1.jpg)

![网站备案流程_网站备案需要什么[简单明了解决备案各种问题]](http://www.vuln.cn/wp-content/uploads/2014/03/topleft.gif)

![最新BurpSuite 1.7.32 破解版[注册机]下载【无后门版】](http://www.vuln.cn/wp-content/uploads/2018/02/ee462f76d3e2440f67041f92499c36ae.png)

![php一句话后门的几种变形分析[preg_replace函数]](http://www.vuln.cn/wp-content/uploads/2016/11/11.jpg)

![[网盘下载] GB/T 23031. 1 — 2022 工业互联网平台 应用实施指南 第一部分:总则.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/3faee12ec28ab59793fbe1c203b8363f.png)

![[网盘下载] GB/T 41870-2022 工业互联网平台 企业应用水平与绩效评价.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/4ec246e126c4f3a41d9ced588c790998.png)

![[网盘下载] GB/T 36323-2018 信息安全技术 工业控制系统安全管理基本要求.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/f6adb0f6fa49a734846c5873d178bfbc.png)

![[网盘下载] GB/T 32919 -2016 信息安全技术 工业控制系统安全控制应用指南.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/da9420e72b7af6bfb4fa273884dcefc1.png)

云悉指纹

云悉指纹