一般在针对性的爬取某个网站的时候可能不需要考虑太多这方面问题,因为一个网站的编码基本是固定的,但是当需要去请求大量编码各不相同的网站时,自动解码就显得尤为重要。

这几天在用requests模块扫描大量网站首页的时候发现有大量的乱码,我们都知道requests中的encoding属性是可以自动识别网页编码的,但是我们往往看到的encoding结果都是“ISO-8859-1”,所以并不能自动识别编码。

在此之前我带大家一起了解下python中的encode/decode函数的编码

python中的编码

字符串在Python内部的表示是unicode编码,因此,在做编码转换时,通常需要以unicode作为中间编码,即先将其他编码的字符串解码(decode)成unicode,再从unicode编码(encode)成另一种编码。

decode的作用是将其他编码的字符串转换成unicode编码,如str1.decode(‘gb2312’),表示将gb2312编码的字符串str1转换成unicode编码,encode的作用是将unicode编码转换成其他编码的字符串,如str2.encode(‘gb2312’),表示将unicode编码的字符串str2转换成gb2312编码。

因此,转码的时候一定要先搞明白,字符串str是什么编码,然后decode成unicode,然后再encode成其他编码。

requests中的编码

先上结论:

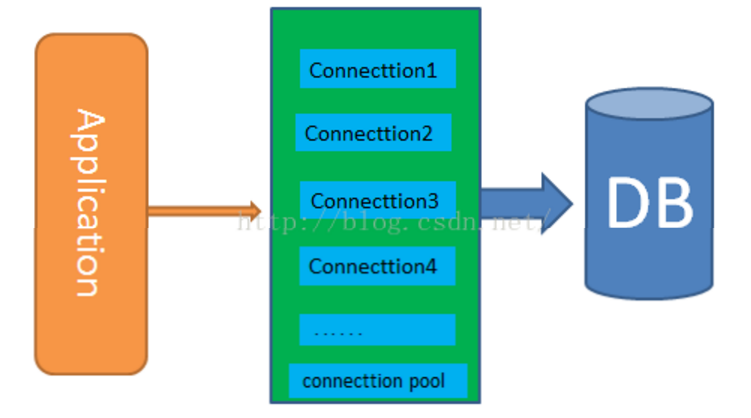

之所以request的响应内容乱码,是因为模块中并没有正确识别出encoding的编码,而s.txt的结果是依靠encoding的编码“ISO-8859-1”解码出的结果,所以导致乱码。

所以正确的逻辑应该这样:

如:

s = requests.get('http://www.vuln.cn')

一般可以先判断出编码,比如编码为gb2312

str = s.content

可以直接用正确的编码来解码

str.decode('gb2312')

那么知道这个逻辑,接下来就是需要正确判断网页编码就行了,

针对这块我在网上找到了不少轮子,原理就是获取响应html中的charset参数:

<meta http-equiv="Content-Type" content="text/html; charset=UTF-8">

但实际上我们并不需要轮子。

因为requests模块中自带该属性,但默认并没有用上,我们看下源码:

def get_encodings_from_content(content):

"""Returns encodings from given content string.

:param content: bytestring to extract encodings from.

"""

charset_re = re.compile(r'<meta.*?charset=["\']*(.+?)["\'>]', flags=re.I)

pragma_re = re.compile(r'<meta.*?content=["\']*;?charset=(.+?)["\'>]', flags=re.I)

xml_re = re.compile(r'^<\?xml.*?encoding=["\']*(.+?)["\'>]')

return (charset_re.findall(content) +

pragma_re.findall(content) +

xml_re.findall(content))还提供了使用chardet的编码检测,见models.py:

@property

def apparent_encoding(self):

"""The apparent encoding, provided by the lovely Charade library

(Thanks, Ian!)."""

return chardet.detect(self.content)['encoding']所以我们可以直接执行encoding为正确编码,让s.txt正确解码即可:

s.encoding = s.apparent_encoding

![Python 获取顶级域名模块ExtractLevelDomain[自定义等级]](http://www.vuln.cn/wp-content/uploads/2017/03/9a773cb04b88be94bfb14287621e1bfe.png)

![Connectify Dispatch指定程序使用指定网卡[运维神器]](http://www.vuln.cn/wp-content/uploads/2016/11/1.jpg)

![网站备案流程_网站备案需要什么[简单明了解决备案各种问题]](http://www.vuln.cn/wp-content/uploads/2014/03/topleft.gif)

![最新BurpSuite 1.7.32 破解版[注册机]下载【无后门版】](http://www.vuln.cn/wp-content/uploads/2018/02/ee462f76d3e2440f67041f92499c36ae.png)

![php一句话后门的几种变形分析[preg_replace函数]](http://www.vuln.cn/wp-content/uploads/2016/11/11.jpg)

![[网盘下载] GB/T 23031. 1 — 2022 工业互联网平台 应用实施指南 第一部分:总则.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/3faee12ec28ab59793fbe1c203b8363f.png)

![[网盘下载] GB/T 41870-2022 工业互联网平台 企业应用水平与绩效评价.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/4ec246e126c4f3a41d9ced588c790998.png)

![[网盘下载] GB/T 36323-2018 信息安全技术 工业控制系统安全管理基本要求.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/f6adb0f6fa49a734846c5873d178bfbc.png)

![[网盘下载] GB/T 32919 -2016 信息安全技术 工业控制系统安全控制应用指南.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/da9420e72b7af6bfb4fa273884dcefc1.png)

云悉指纹

云悉指纹