2017-9-1

15114

0

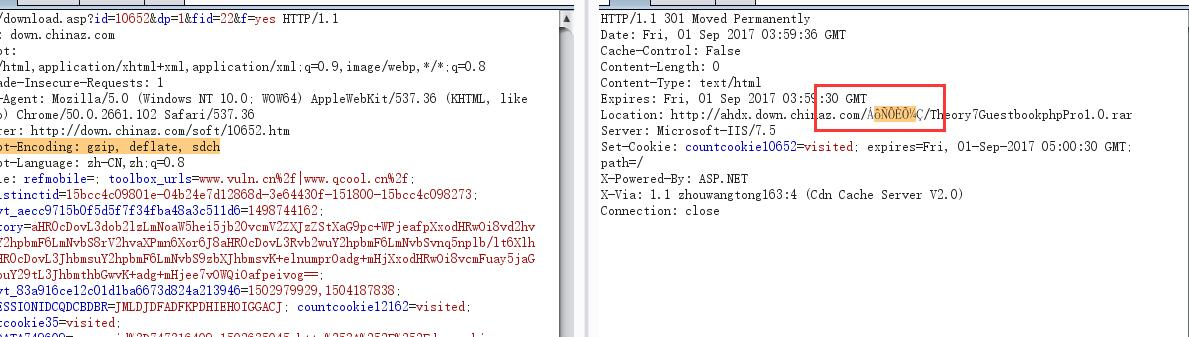

问题表现:

响应头中有gbk编码的中文,导致requests无法解码读取header。

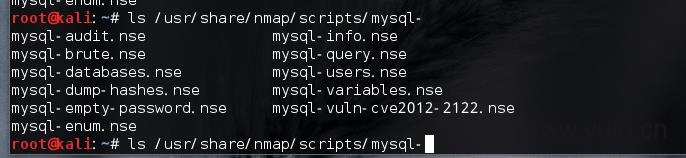

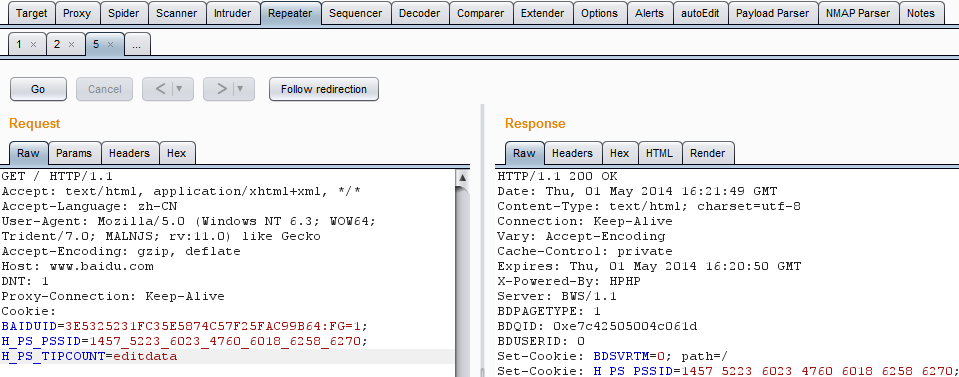

http包如图:

Python 3.4.3 (default, Aug 25 2017, 16:49:50)

[GCC 4.8.5 20150623 (Red Hat 4.8.5-11)] on linux

Type "help", "copyright", "credits" or "license" for more information.

>>> import requests

>>> res = requests.get('http://down.chinaz.com/download.asp?id=35&…继续阅读 »

2017-6-22

10505

0

背景:

多线程跑系统识别,当某线程得到结果后,需要优雅的停止平行的其他线程,结束本次任务。

Python threading模块不同于其它语言之处在于它没有提供线程的终止方法,而且python的多线程设计本身也是不希望用户这么做,但是很多时候我们得到某个结果后为了节省不必要的资源 必须停止其他线…继续阅读 »

2017-6-22

17661

0

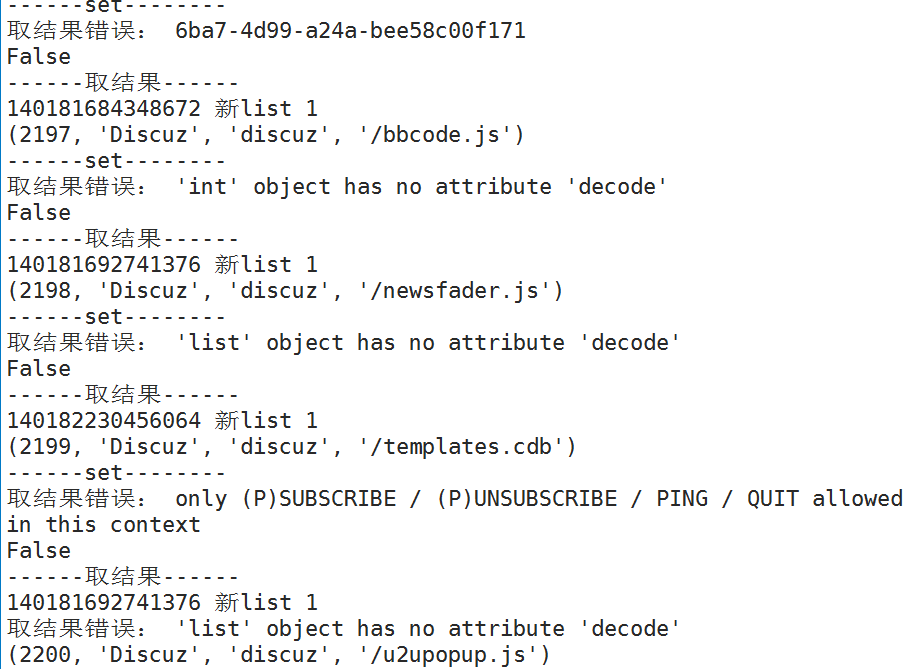

这个问题困扰了我估计有一个星期问题,而问题的一开始我没有任何头绪,问题的表现就是调用节点去请求任务时,时常报错:

报错信息诸如:

Protocol Error: , b'\x00\x00\x00\x00\x00\x00\x00\x00\x00*3'

Error while reading from socket: (9, 'Bad file descriptor')

'int' object has no attribute 'decode'

name 'self' is not defined

only …继续阅读 »

2017-5-8

27084

0

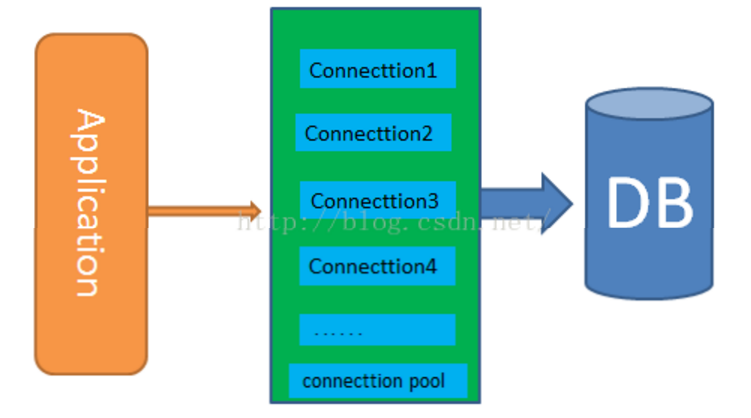

随着全网扫描项目的开发,越来越细致的问题暴露出来,从能用到用的好,还有很长的路要走。

这个问题前段时间就发现了,程序一般跑个一天会越来越慢,直到某个时候程序彻底崩了,而且最后的报错也一般是mysql的报错:

pymysql.err.OperationalError: (2013, 'Lost connection to MySQL server during query ([Errno 104] Co…继续阅读 »

2017-4-5

37886

0

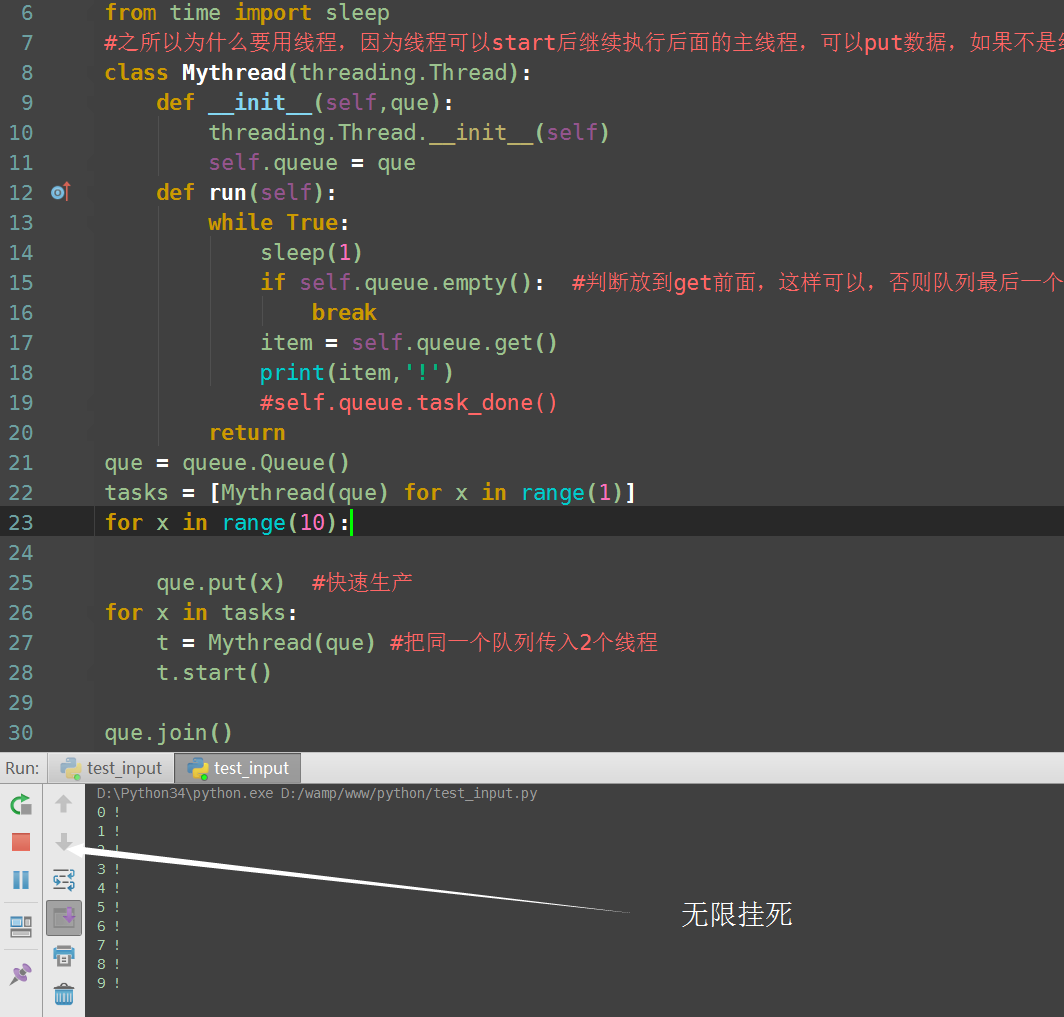

在网上大多关于join()与task_done()的结束原话是这样的:

Queue.task_done() 在完成一项工作之后,Queue.task_done()函数向任务已经完成的队列发送一个信号

Queue.join() 实际上意味着等到队列为空,再执行别的操作

但是可能很多人还是不太理解,这里以我自己的理解来阐述这两者的关联。

理解

如果线程里…继续阅读 »

2017-3-27

20880

0

终究,我还是从innodb转到了myisam,光innodb库的大小就够我受的,更别说查询速度了。

但是我遇到了一个问题,从innodb转到myisam很快就能完成,ibdata1文件还是那么大,有27G。

嗯,可以理解,可能因为我的库还在。

但是当我删除一个大库的时候瞬间就完成了,那一瞬间我就感觉不妙,几百万的数据…继续阅读 »

2017-3-22

9183

0

此贴为备忘帖:

背景:将mysql 的var目录数据全部迁移至另一mysql服务器,权限正常的情况下 无法启动mysql,报错:

ERROR! MySQL is not running, but lock file (/var/lock/subsys/mysql) exists

查看var下的localhost.localdomain.err日志,报错为:

170322 14:47:52 mysqld_safe Starting mysqld daemon with databases from /usr/local/mysql/var

170322 …继续阅读 »

2017-3-22

16107

0

一般在针对性的爬取某个网站的时候可能不需要考虑太多这方面问题,因为一个网站的编码基本是固定的,但是当需要去请求大量编码各不相同的网站时,自动解码就显得尤为重要。

这几天在用requests模块扫描大量网站首页的时候发现有大量的乱码,我们都知道requests中的encoding属性是可以自动识别网…继续阅读 »

2017-3-17

9002

0

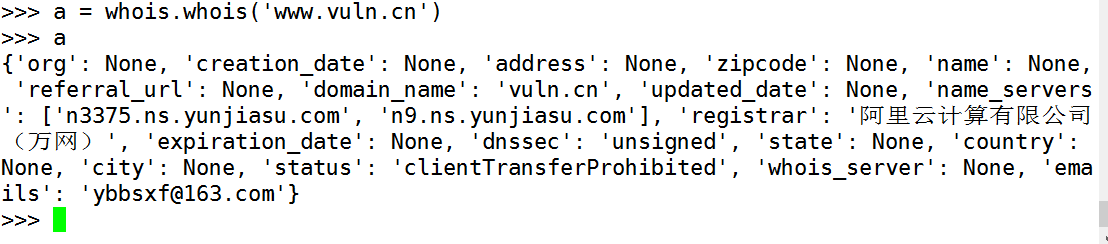

这个模块在很多爬虫项目里应该还是挺实用的,不过我是用来批量查询whois和备案单位的,因为库里有大量的子域名,所以只需要对同顶级域名的其中一个域名获取信息即可,否则会造成数据库大量冗余信息,而且在后期更新的时候还会造成系统及网络不必要的压力。

找了这么个提取顶级域名的模…继续阅读 »

2017-3-16

11553

0

全网域名扫描项目还在进行中,之前想的很简单的whois提取本以为很简单,看了下linux下whois出来的结果格式很多都不一样,自己写的话是比较麻烦的。

在线接口的话找了很多,还是只有站长之家最靠谱,但是由于量很大,而且又有请求限制,还是决定再找找whois的轮子,找了两个,一个很烂,.cn .com…继续阅读 »

![Python 获取顶级域名模块ExtractLevelDomain[自定义等级]](http://www.vuln.cn/wp-content/uploads/2017/03/9a773cb04b88be94bfb14287621e1bfe.png)

![Connectify Dispatch指定程序使用指定网卡[运维神器]](http://www.vuln.cn/wp-content/uploads/2016/11/1.jpg)

![网站备案流程_网站备案需要什么[简单明了解决备案各种问题]](http://www.vuln.cn/wp-content/uploads/2014/03/topleft.gif)

![最新BurpSuite 1.7.32 破解版[注册机]下载【无后门版】](http://www.vuln.cn/wp-content/uploads/2018/02/ee462f76d3e2440f67041f92499c36ae.png)

![php一句话后门的几种变形分析[preg_replace函数]](http://www.vuln.cn/wp-content/uploads/2016/11/11.jpg)

![[网盘下载] GB/T 23031. 1 — 2022 工业互联网平台 应用实施指南 第一部分:总则.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/3faee12ec28ab59793fbe1c203b8363f.png)

![[网盘下载] GB/T 41870-2022 工业互联网平台 企业应用水平与绩效评价.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/4ec246e126c4f3a41d9ced588c790998.png)

![[网盘下载] GB/T 36323-2018 信息安全技术 工业控制系统安全管理基本要求.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/f6adb0f6fa49a734846c5873d178bfbc.png)

![[网盘下载] GB/T 32919 -2016 信息安全技术 工业控制系统安全控制应用指南.pdf](http://www.vuln.cn/wp-content/uploads/2023/02/da9420e72b7af6bfb4fa273884dcefc1.png)

云悉指纹

云悉指纹

最新评论

陆邀请码

test那个配置文件的路径在哪里啊

小山支持

Big Tree我和你一样的反应

8848666